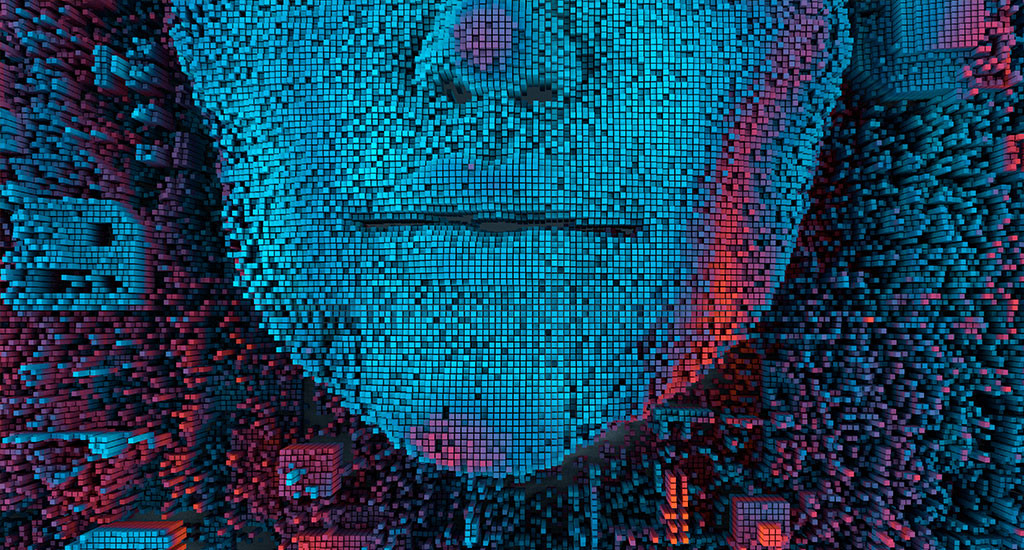

deepfake

deepfake – sostantivo

Google has released a database of 3,000 deepfakes – videos that use artificial intelligence to alter faces or to make people say things they never did.

Deepfake videos are quickly becoming a problem, but there has been much debate about just how big the problem really is.

Pare proprio che modi di dire quali ‘Vedere per credere’ e ‘La macchina da presa non mente mai’ siano oggi obsoleti. Non possiamo più credere ai nostri occhi e la macchina (o la persona dietro la macchina) mente, eccome, per trarci in inganno. Certo, immagini e video fasulli sono sempre esistiti, ma adesso è entrato in ballo un nuovo uso dell’intelligenza artificiale: manipolare video per crearne altri in cui il soggetto ripreso sembra dire e fare cose che in realtà non ha mai detto o fatto, con una verosimiglianza sbalorditiva. Tutto sembra aver avuto inizio con la comparsa a inizio 2018 dell’applicazione FakeApp; il codice sviluppato per i deepfake è open source, perciò chiunque abbia anche solo un minimo di conoscenze informatiche può creare video fasulli assolutamente convincenti. E se i deepfake sono stati prodotti nel corso di legittime ricerche nel campo informatico, la tecnologia è stata usata nel cinema e, riprovevolmente, per creare video di propaganda politica e pornografia. Come accade di frequente nel caso di nuove tecnologie, la società e il legislatore arrancano a star dietro ai mutamenti; nel frattempo, il consiglio più saggio è forse quello di essere più critici e non credere ai nostri occhi.

Origini del termine

Anche se l’idea di realizzare video fasulli assolutamente credibili è in giro da un pezzo, deepfake è un termine nuovo che descrive una tecnologia sviluppata di recente. Si tratta di una parola macedonia formata dai sostantivi deep learning e fake che pare origini dal nick di un utente del sito Reddit, alla fine del 2017.

Traduzione di Loredana Riu

deepfake – noun

Google has released a database of 3,000 deepfakes – videos that use artificial intelligence to alter faces or to make people say things they never did.

Deepfake videos are quickly becoming a problem, but there has been much debate about just how big the problem really is.

Expressions such as ‘Seeing’s believing’ and ‘The camera never lies’ may now be obsolete. You can’t believe everything you see, and the camera (or the person behind it) may be lying in order to deceive you. The reason for this is a new use for artificial intelligence: manipulating video in order to create videos in which people seem to say and do things they have never said or done. The appearance in early 2018 of an app called FakeApp and the subsequent adaptation of its software into open source alternatives means that almost anyone can create fake videos so convincing that they are impossible to tell from genuine ones. While deepfakes have been produced in the course of bona fide research by computer science, the technology has also been used in cinema and, less desirably, to create political attack videos and pornography. As is so frequently the case with new technology, society and the law are scrabbling to catch up; and in the meantime the best advice is probably not to trust the evidence of your own eyes.

Origin

Although the idea of faked video good enough to deceive everyone has been around for several decades, deepfake is a brand new term for techniques that didn’t exist just a few years back. The word is a blend formed from the noun deep learning and the noun fake. It seems to have been first used around the end of 2017 as a username on the website Reddit